Die llms.txt-Datei ist ein sich entwickelnder Standard, der Website-Betreibern ermöglicht, Large Language Models (LLMs) wie ChatGPT oder Google Gemini spezifische Anweisungen zum Crawling, zur Indexierung und zur Nutzung ihrer Inhalte zu geben. Sie dient als Leitfaden für KI-Systeme, um Web-Inhalte effizienter und im Einklang mit den Präferenzen des Content-Eigentümers zu verstehen und zu verarbeiten.

Funktionsweise und Struktur

Ähnlich wie die etablierte robots.txt-Datei für Suchmaschinen-Crawler wird die llms.txt-Datei im Root-Verzeichnis einer Website (z. B. ihredomain.de/llms.txt) platziert. Ihr primäres Ziel ist es jedoch nicht, das Crawling gänzlich zu unterbinden, sondern vielmehr, Kontext und Anweisungen zur Verwendung der Inhalte bereitzustellen.

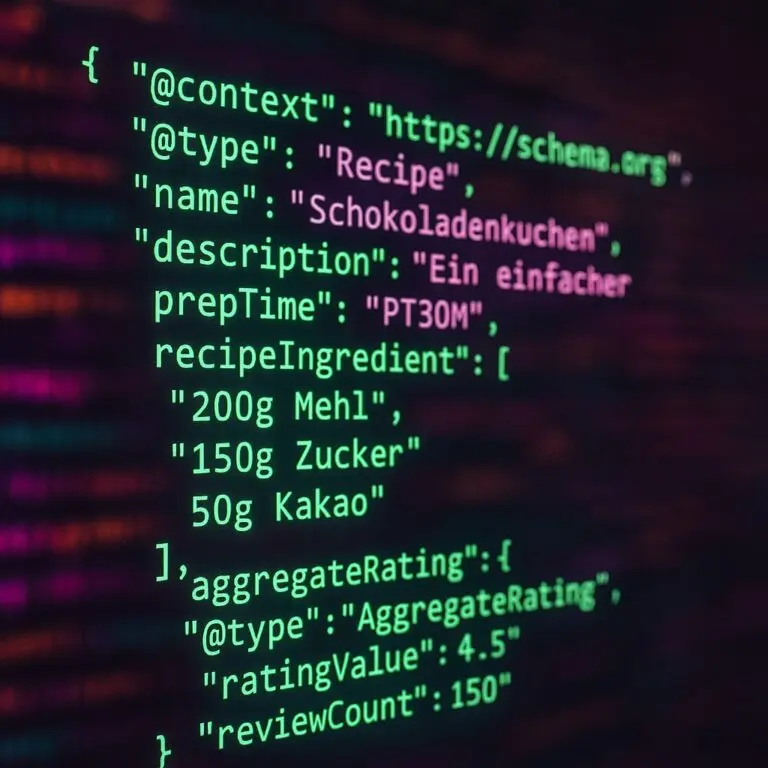

Die Datei ist in der Regel als Markdown-Dokument formatiert, was sie sowohl für Menschen als auch für KI-Systeme leicht lesbar macht. Eine typische llms.txt-Datei enthält:

- Einen H1-Titel mit dem Namen des Projekts oder der Website.

- Einen Blockquote mit einer kurzen Zusammenfassung des Projekts, der die wichtigsten Informationen für das Verständnis des Inhalts liefert.

- Organisierte Abschnitte mit relevanten Links zu detaillierteren Inhalten oder Dokumentationen.

Es gibt auch Überlegungen zu Varianten wie llms-full.txt, die den gesamten Inhalt in einer einzigen Datei bereitstellt, um LLMs den Zugriff auf umfassende Dokumentationen zu erleichtern.

Bedeutung für Webmaster und die KI-Landschaft

Die Einführung von llms.txt adressiert mehrere Herausforderungen im Umgang mit KI-Systemen und Web-Inhalten. Moderne Websites sind oft komplex, nutzen JavaScript und dynamische Inhalte, die für LLM-Crawler schwer zu interpretieren sind. Zudem existiert eine Fülle an Informationen, und es ist für KI-Systeme nicht immer klar, welche Inhalte relevant oder wichtig sind.

Durch die Bereitstellung einer strukturierten und kuratierten Inhaltsübersicht ermöglicht llms.txt den LLMs, die wesentlichen Informationen einer Website schneller und genauer zu erfassen. Dies kann die Qualität der von KI-Modellen generierten Antworten verbessern, die auf diesen Daten basieren.

Für Website-Betreiber bietet llms.txt eine Möglichkeit, mehr Kontrolle darüber zu gewinnen, wie ihre Inhalte von KI-Systemen genutzt werden, insbesondere im Hinblick auf Datenschutz, Urheberrecht und die Prävention von Fehlinformationen. Obwohl die Einhaltung freiwillig ist, gewinnt dieser Standard an Bedeutung, da immer mehr Nutzer KI-Assistenten für die Informationssuche verwenden.