Crawling beschreibt den automatisierten Prozess, bei dem Suchmaschinen-Bots, auch bekannt als Crawler, Spider oder Webcrawler, das Internet systematisch durchsuchen, um Webseiten zu entdecken und deren Inhalte zu erfassen. Dieser Vorgang ist der erste und grundlegende Schritt, damit eine Webseite überhaupt in den Suchergebnissen erscheinen kann. Crawler navigieren von einer bekannten URL zu weiteren, indem sie Hyperlinks auf den besuchten Seiten folgen und so ein riesiges, miteinander verbundenes Netzwerk von Webseiten abbilden.

Wie funktioniert der Crawling-Prozess?

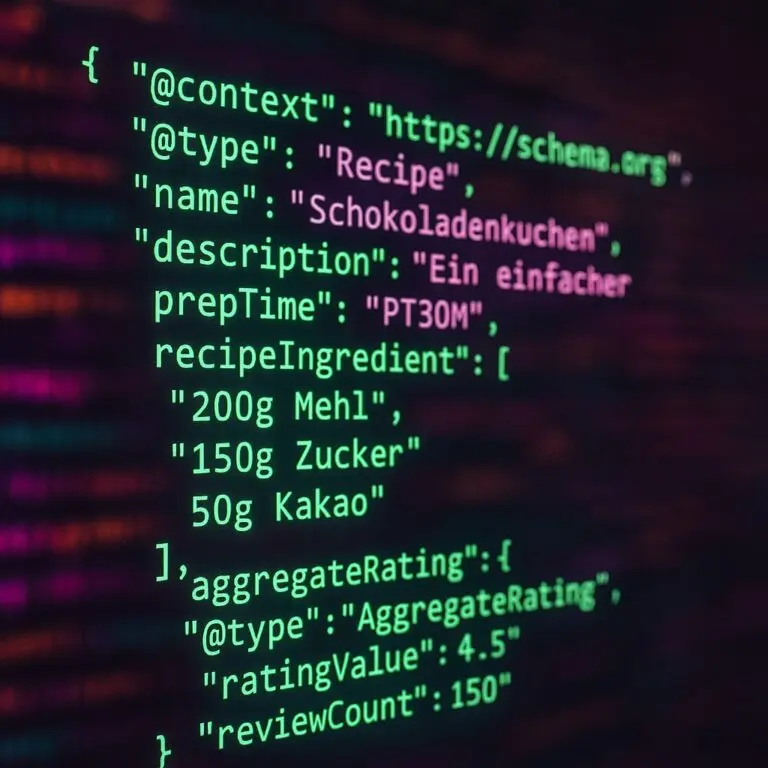

Ein Webcrawler startet mit einer sogenannten “Seed-Liste” von URLs und ruft diese Seiten ab. Während dieses Prozesses analysiert er den HTML-Code und identifiziert weitere interne und externe Links. Diesem Link-Geflecht folgt der Bot dann, um neue Seiten zu finden, die bislang unbekannt sind, oder um Änderungen an bereits erfassten Seiten zu erkennen. Die gesammelten Informationen umfassen Texte, Bilder, Videos und weitere Dateitypen. Diese Daten werden an die Server der Suchmaschine übermittelt, wo sie für die weitere Verarbeitung – die Indexierung – vorbereitet werden.

Die Frequenz und Intensität, mit der ein Crawler eine Webseite besucht, hängt von verschiedenen Faktoren ab. Dazu zählen die Popularität und Aktualität der Inhalte, die Ladegeschwindigkeit der Website sowie die Stabilität des Servers. Große und häufig aktualisierte Webseiten werden in der Regel öfter gecrawlt als kleinere oder statische Seiten.

Bedeutung für SEO und Steuerung des Crawlings

Für die Suchmaschinenoptimierung (SEO) ist Crawling von entscheidender Bedeutung, da es die Voraussetzung für die Indexierung und somit für die Sichtbarkeit einer Webseite in den Suchergebnissen ist. Eine Seite, die nicht gecrawlt werden kann, kann auch nicht im Index einer Suchmaschine aufgenommen werden und folglich nicht ranken.

Webseitenbetreiber können den Crawling-Prozess gezielt steuern, um Suchmaschinen-Bots die Arbeit zu erleichtern und Ressourcen effizient zu nutzen:

robots.txt: Diese Textdatei, die im Hauptverzeichnis einer Webseite liegt, gibt Suchmaschinen-Crawlern Anweisungen, welche Bereiche der Seite sie crawlen dürfen und welche nicht. Dies ist nützlich, um unnötige oder sensible Inhalte vom Crawling auszuschließen und so das sogenannte Crawl Budget zu optimieren.- Sitemap (

sitemap.xml): Eine XML-Sitemap ist eine Datei, die alle relevanten URLs einer Webseite auflistet. Sie dient Suchmaschinen als eine Art Wegweiser, um alle wichtigen Seiten schnell und vollständig zu entdecken und zu crawlen. Die Sitemap kann in derrobots.txt-Datei verlinkt oder direkt in Tools wie der Google Search Console eingereicht werden. - Crawl Budget: Der Begriff Crawl Budget bezeichnet die Menge an Ressourcen (Zeit und Kapazität), die eine Suchmaschine für das Crawling einer bestimmten Webseite innerhalb eines Zeitrahmens aufwendet. Eine effiziente Nutzung des Crawl Budgets ist besonders für große Webseiten wichtig, um sicherzustellen, dass alle relevanten Inhalte regelmäßig gecrawlt und indexiert werden.

Durch die Optimierung der technischen Struktur, eine klare interne Verlinkung und die Vermeidung von Crawling-Fehlern stellen Webseitenbetreiber sicher, dass ihre Inhalte von Suchmaschinen korrekt erfasst und in den Suchergebnissen präsentiert werden können.